2025年 | プレスリリース・研究成果

触覚情報により表裏を判断しロボットの両手運動を自動生成するAI 技術を開発 ─ 視覚と触覚情報の統合で人間に近い動きを実現 ─

【本学研究者情報】

〇大学院工学研究科 ロボティクス専攻

教授 林部 充宏

研究室ウェブサイト

【発表のポイント】

- ロボットがカメラ画像(視覚)に加えて触覚センサーの情報から、環境に応じた両手操作の動作手順を自動生成し運動制御するフレームワークを開発しました。

- 視覚情報のみでは判断が難しい、対象物の質感に基づく操作判断が可能となり、より柔軟で適応性の高いロボット制御が実現します。

- 本成果は、視覚・聴覚・触覚など複数の感覚を統合処理するマルチモーダルAI(注1)の実現に向けた重要な一歩であり、今後のロボットの高度化・実用化に貢献すると期待されます。

【概要】

近年、人工知能(AI)を支える機械学習を用いて人間の動作パターンを学習し、ロボットが調理や掃除などの日常タスクを自律的に実行する研究が進んでいます。その技術の進歩は日進月歩です。しかし、これらは主に視覚情報に依存しており、素材の質感や表裏の違いなど触覚的な判断を伴う作業には限界がありました。

東北大学大学院工学研究科のNingquan Gu大学院生と林部充宏教授は、香港大学および香港の研究機関であるCentre for Transformative Garment Production(TransGP)の小菅一弘教授(東北大学名誉教授)との共同研究により、視覚と触覚の情報を統合し、ロボットの両手操作を環境適応的に自動生成するフレームワーク「TactileAloha」を開発しました。これにより、マジックテープ(注2)やジップタイ(注3)のような表裏の違いや接着性が重要となる作業においても、ロボットが触って判断し、両手を使って適切に操作することが可能になります。従来の視覚ベースの手法と比較して高いタスク成功率を達成し、実用化への道を大きく前進させました。

本研究成果は、米国電気電子学会が発行するロボット工学の専門誌IEEE Robotics and Automation Lettersに2025年7月2日付けで掲載されました。

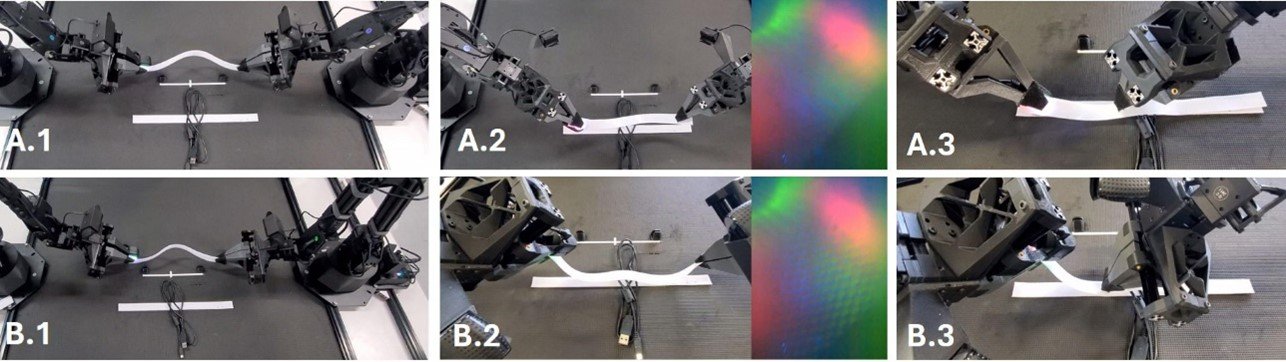

図1. カメラ情報を基にアームはマジックテープの両端を掴む(A.1、B.1)。触覚情報によりテープの向きを感知し、フック面がループ面と合うように姿勢と角度を調整して位置合わせを行う(A.2、B.2)。マジックテープを固定し、右アームが押し付けて確実に結合させる(A.3、B.3)。与えられたテープの面に適応して、適切な接触面となるよう異なるテープ操作運動が自動生成される。

【用語解説】

注1. マルチモーダルAI:マルチモーダルAIは、テキスト・画像・音声・動画など複数の異なるデータ形式を同時に処理・理解する人工知能技術です。従来の単一データ処理と異なり、人間のように複数の感覚情報を統合して総合的な判断を行います。

注2. マジックテープ:マジックテープは、表面に微細なフック状突起がある面とループ状繊維がある面を貼り合わせて接着する面ファスナーです。1948年にスイスで発明され、衣類・靴・バッグなどに広く使用されています。簡単に着脱でき、繰り返し使用可能な便利な接合材料です。

注3. ジップタイ:ジップタイ(結束バンド)は、プラスチック製の帯状ストラップで、一方向にのみ締まる仕組みを持つ固定具です。電線の束ね、配管固定、梱包作業などに広く使用され、安価で簡単に使える便利な工業用品として、建設・電気・物流分野で重宝されています。

【論文情報】

タイトル:TactileAloha: Learning Bimanual Manipulation with Tactile Sensing

著者:Ningquan Gu, Kazuhiro Kosuge, Mitsuhiro Hayashibe*

*責任著者:東北大学 大学院工学研究科 教授 林部充宏

掲載誌:IEEE Robotics and Automation Letters

DOI:10.1109/LRA.2025.3585396

問い合わせ先

(研究に関すること)

東北大学大学院工学研究科 ロボティクス専攻 教授 林部 充宏

TEL: 022-795- 6970 Email: hayashibe*tohoku.ac.jp

(*を@に置き換えてください)

(報道に関すること)

東北大学大学院工学研究科 情報広報室 担当 沼澤 みどり

TEL: 022-795-5898 Email: eng-pr*grp.tohoku.ac.jp

(*を@に置き換えてください)

![]()

東北大学は持続可能な開発目標(SDGs)を支援しています